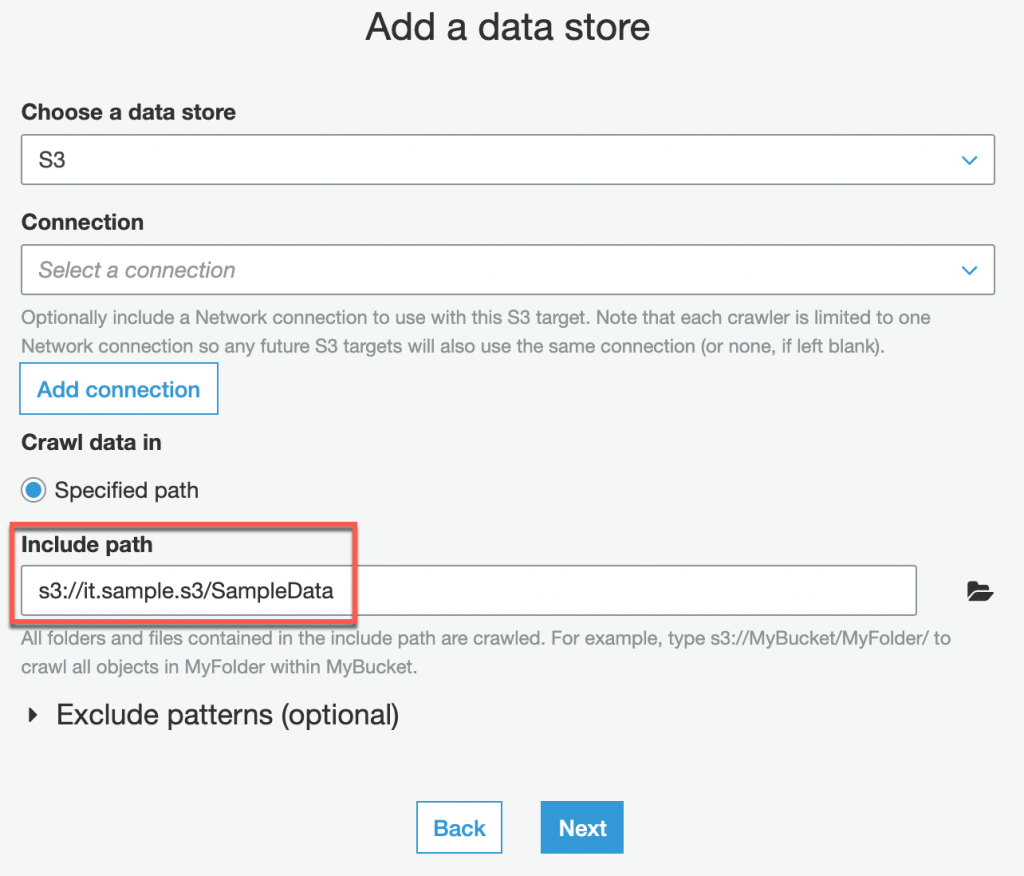

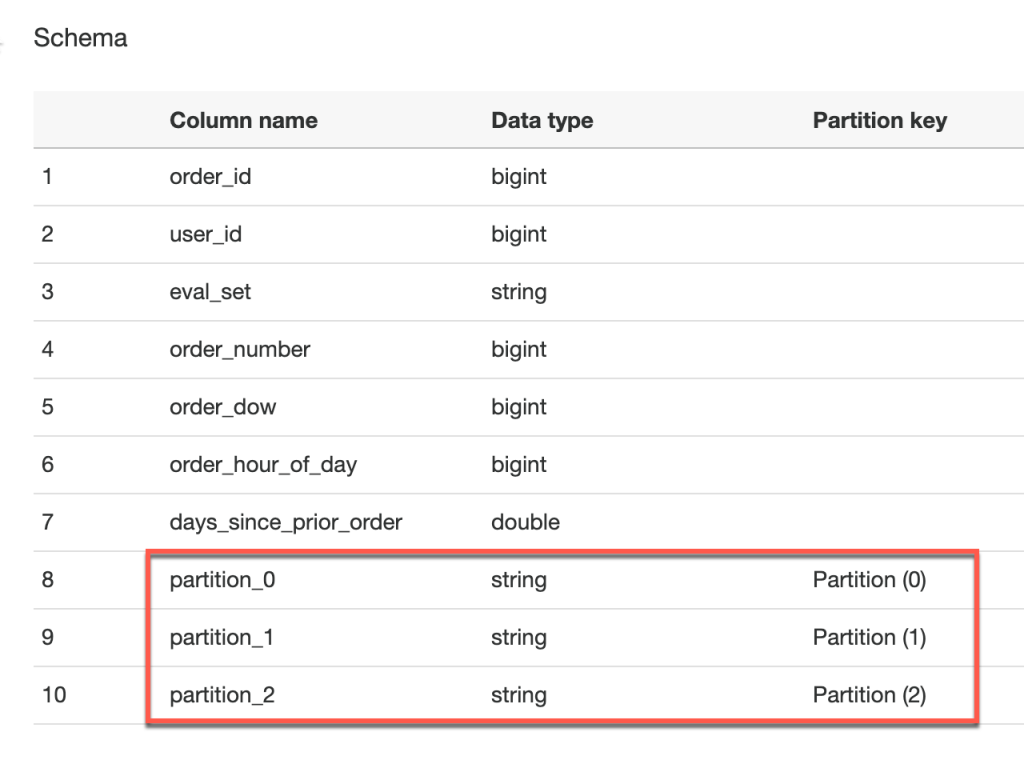

今天要來補充一下昨天的小細節,昨天有介紹完 Workflow 的使用方式,可以正常產生出每個User購買最多的前五名商品,但如果是使用昨天的 S3 資料階層來當資料源時(如下),因為我們加入了年月日也就是 Partition,所以 Data Catalog 需要修改部分設定才能正常工作

it.sample.s3

㇄SampleData

㇄order

⎢ ㇄2020

⎢ ㇄01

⎢ ㇄01

⎢ ㇄orders.csv

㇄order_products_prior

⎢ ㇄2020

⎢ ㇄01

⎢ ㇄01

⎢ ㇄order_products__prior.csv

㇄order_products_train

⎢ ㇄2020

⎢ ㇄01

⎢ ㇄01

⎢ ㇄order_products__train.csv

㇄products

⎢ ㇄2020

⎢ ㇄01

⎢ ㇄01

⎢ ㇄products.csv

㇄sample_submission

⎢ ㇄2020

⎢ ㇄01

⎢ ㇄01

⎢ ㇄sample_submission.csv

㇄departments

⎢ ㇄2020

⎢ ㇄01

⎢ ㇄01

⎢ ㇄departments.csv

㇄aisles

㇄2020

㇄01

㇄01

㇄aisles.csv

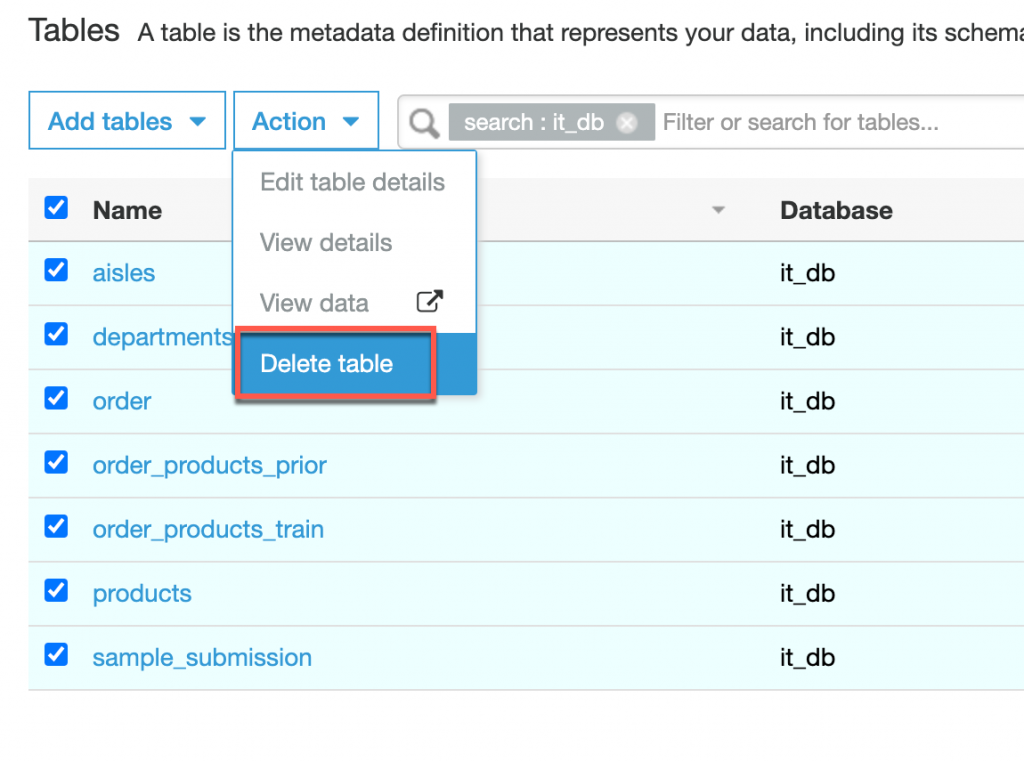

接下來我們來說明 Data Catalog 需要如何修改